摘要:2025年,度量用户、湖南大学周易教授作为通讯作者在机器人顶刊IEEE TRO上发表两篇论文,在基于事件相机的研究中取得重要进展。动捕数据助力验证论文提出的方法。

2025年,度量用户、湖南大学周易教授作为通讯作者在机器人顶刊IEEE TRO上发表两篇论文,在基于事件相机的研究中取得重要进展。动捕数据助力验证论文提出的方法。

论文一

Event-based Visual-Inertial State Estimation for High-Speed Maneuvers

周易教授采访视频

RSS 2024 “Event-based Visual Inertial Velometer”

2024年,周易教授团队在机器人顶会RSS上发表论文“Event-based Visual Inertial Velometer”。时隔一年,研究团队进一步完善了算法,增加了更多真实高速场景下的实验验证,证明了该方法在低延迟和高精度方面的优越性能。并在机器人顶刊IEEE TRO上发表论文“Event-Based Visual-Inertial State Estimation for High-Speed Maneuvers”。

引用格式

X. Lu, Y. Zhou, J. Mai, K. Dai, Y. Xu and S. Shen, "Event-Based Visual-Inertial State Estimation for High-Speed Maneuvers," in IEEE Transactions on Robotics, vol. 41, pp. 4439-4458, 2025, doi: 10.1109/TRO.2025.3584544.

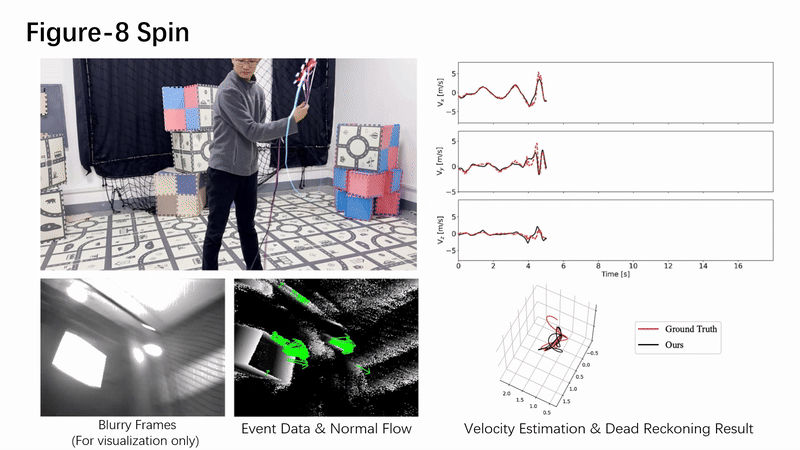

该论文创新性地提出了一种基于事件相机(Event Camera)和惯性测量单元(IMU)的高速运动状态估计方法,首次实现了仅依赖事件流与惯性数据的实时线性速度估计,为无人机、高速机器人等动态场景下的精准定位提供了新思路。研究团队从第一性原理出发创新性地提出了一种“速度计”式设计,通过融合立体事件相机的稀疏法向流和IMU数据,利用连续时间B样条模型直接估计瞬时线速度,避免了传统方法对特征匹配或环境结构的依赖。实验表明,在真实高速场景(如无人机急转、绳索旋转等)中,该方法的速度估计误差比现有技术降低50%以上,且计算效率满足实时性需求。

动作捕捉系统为本文提供事件相机轨迹真值,助力验证本文方法。

论文二

ESVO2: Direct Visual-Inertial Odometry With Stereo Event Cameras

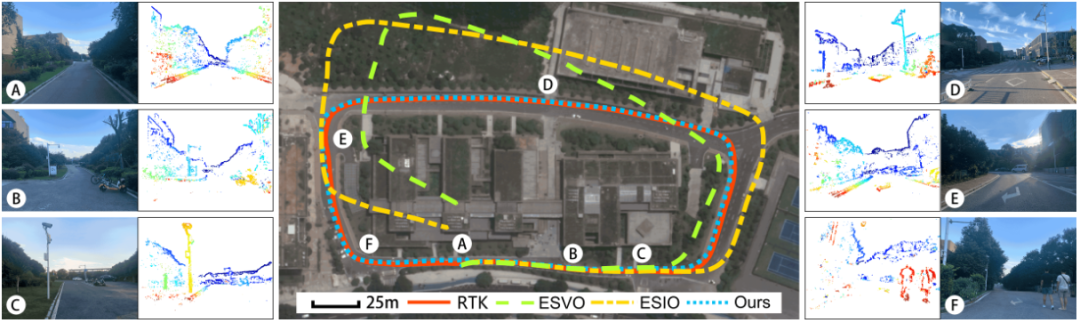

周易教授团队在先前的研究基础之上进行了创新性改进,提出了基于事件相机的双目视觉与惯性里程计系统,着重优化了3D建图效率与位姿估计精度。研究成果以“ESVO2: Direct Visual-Inertial Odometry with Stereo Event Cameras”为题发表在机器人顶刊IEEE TRO。

引用格式

J. Niu, S. Zhong, X. Lu, S. Shen, G. Gallego and Y. Zhou, "ESVO2: Direct Visual-Inertial Odometry With Stereo Event Cameras," in IEEE Transactions on Robotics, vol. 41, pp. 2164-2183, 2025, doi: 10.1109/TRO.2025.3548523.

通过设计新型边缘点的采样策略并融合前后帧与左右目的深度信息,本研究有效提升了建图模块的完整性与计算效率;针对相机位姿估计中俯仰与偏航分量的退化问题,该研究通过引入IMU测量数据作为运动先验,构建紧凑且稳健的后端优化框架,实现IMU偏置与线速度的实时估计。实验表明,相较于现有主流算法,研究所提出的系统在大尺度室外场景下展现出更高的定位精度和更为优秀的实时性能。

湖南大学校园内的定位实验结果展示

动作捕捉系统为本文提供轨迹真值,助力验证本文方法。

通讯作者介绍

周易,湖南大学机器人学院教授、博士生导师,湖南大学NAIL实验室主任。2018年于澳大利亚国立大学工程与计算机学院取得博士学位,入选国家高水平青年人才计划。主要从事基于先进视觉传感器的机器人感知与导航技术研究,包括高速自主机器人技术、视觉里程计(VO/SLAM)、动态视觉传感器 (Event-based Vision),多视角几何理论等。主要科研成果发表在IEEE T-RO,RSS,ECCV等机器人与计算机视觉的权威刊物,目前担任IEEE RA-L副主编。

关于NAIL实验室:

https://sites.google.com/view/zhouyi-joey/home