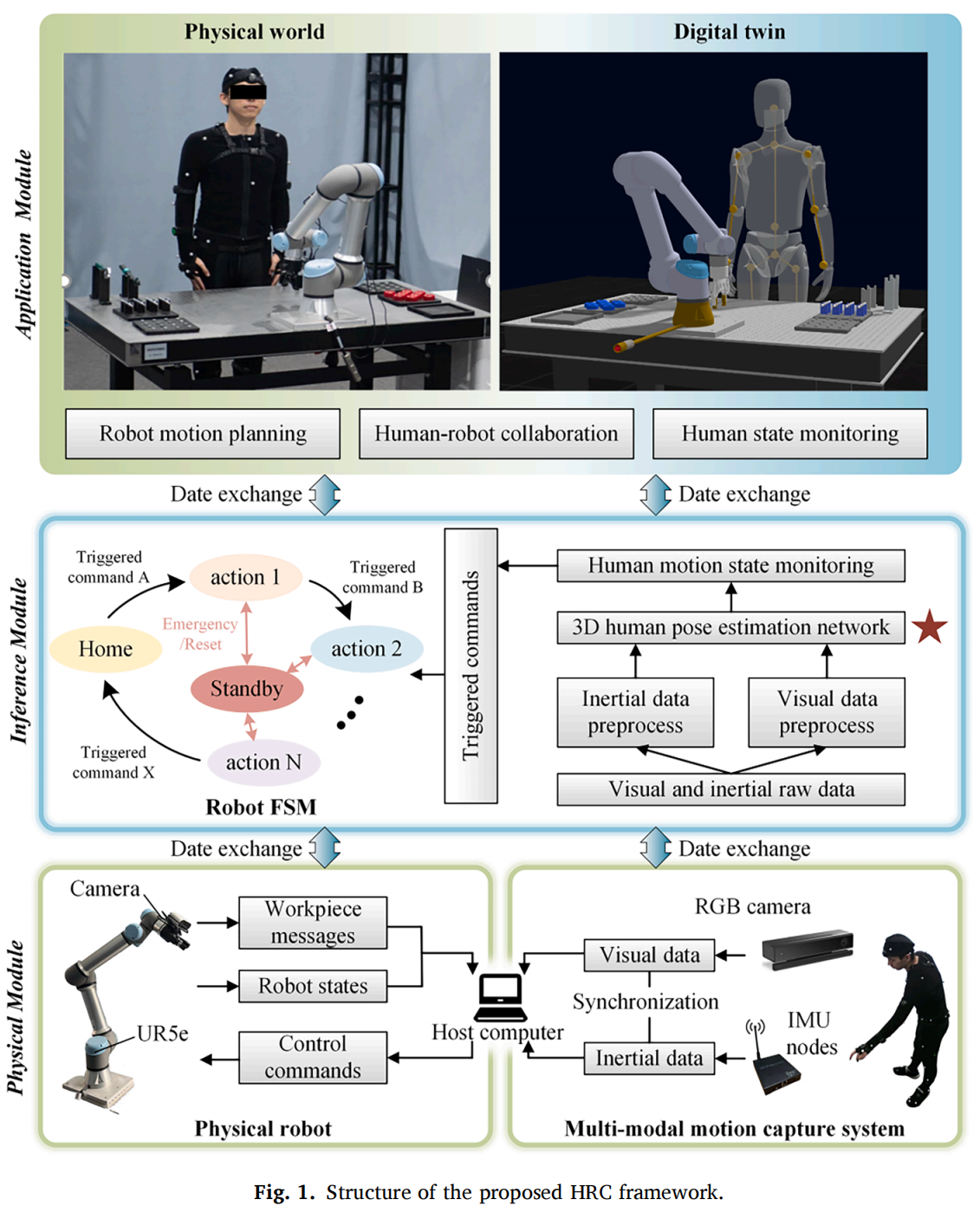

浙江大学机械工程学院研究团队在中科院一区期刊Robotics and Computer-Integrated Manufacturing发表论文 “A deep learning-enabled visual-inertial fusion method for human pose estimation in occluded human-robot collaborative assembly scenarios”。

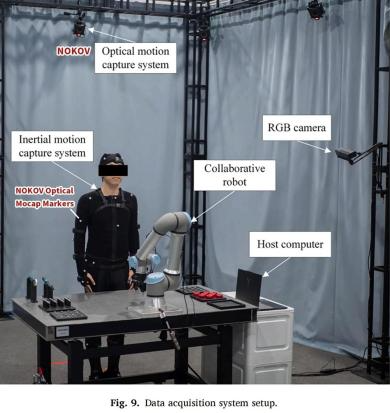

该研究聚焦以人为核心的智能制造场景,提出了一种基于视觉-惯性融合的人体姿态估计方法,以降低工业环境中遮挡对人体姿态估计的影响。NOKOV度量动作捕捉系统为研究提供人体姿态真值,助力验证本文方法。

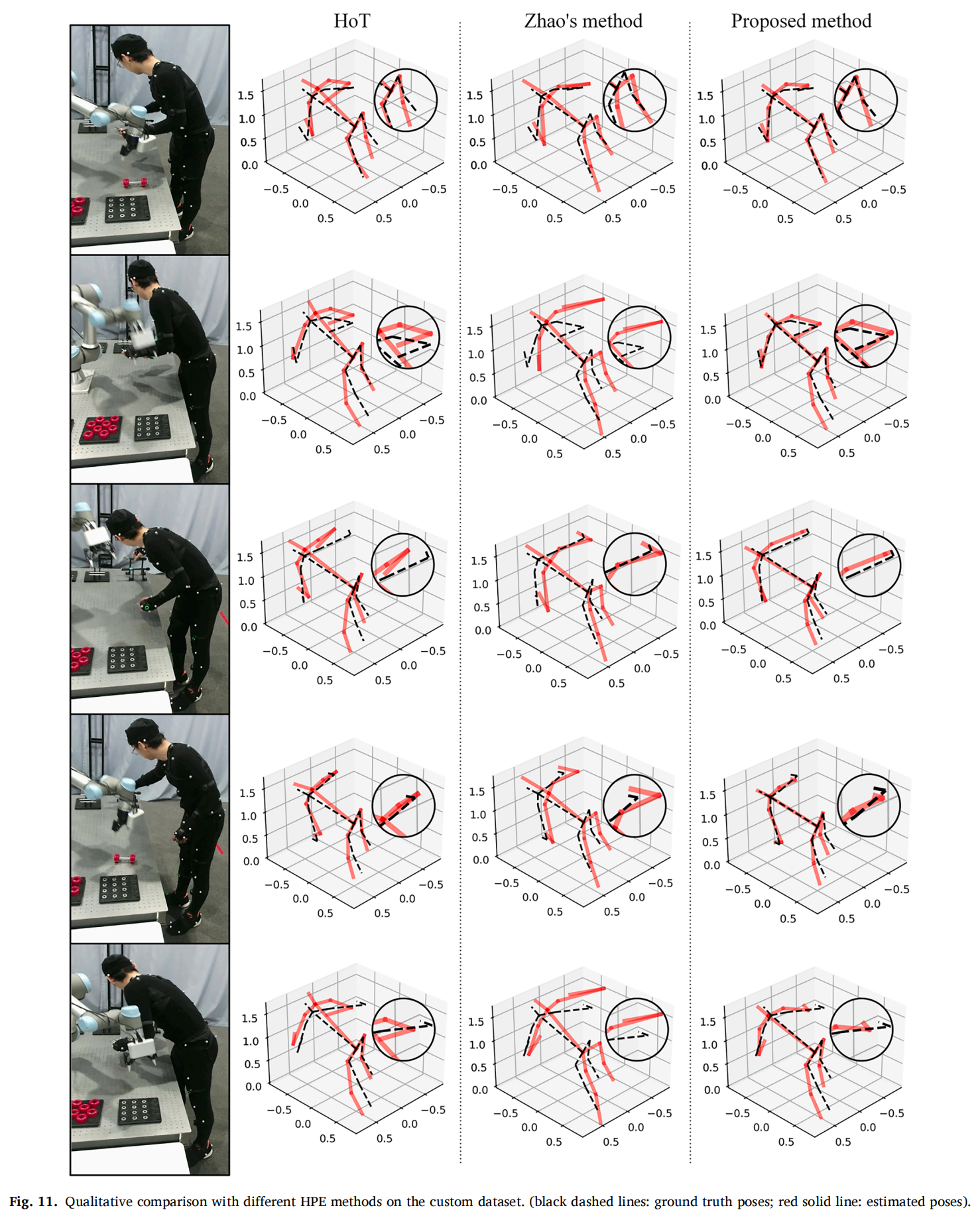

与最新方法相比,本文提出的人体姿态估计(HPE)方法在公共数据集和自定义数据集上均展现出更高的准确性,并在遮挡场景中表现出鲁棒性。本文贡献总结如下:

1、提出了一种新型的基于视觉-惯性融合的 HPE 方法,适用于遮挡人机协作(HRC)场景,使用一个 RGB 相机和稀疏 IMUs 作为输入,平衡了算法性能和操作人员舒适度。

2、设计了一种基于特定部位的跨模态变换器融合块,整合不同模态的空间特征,促进数据融合。

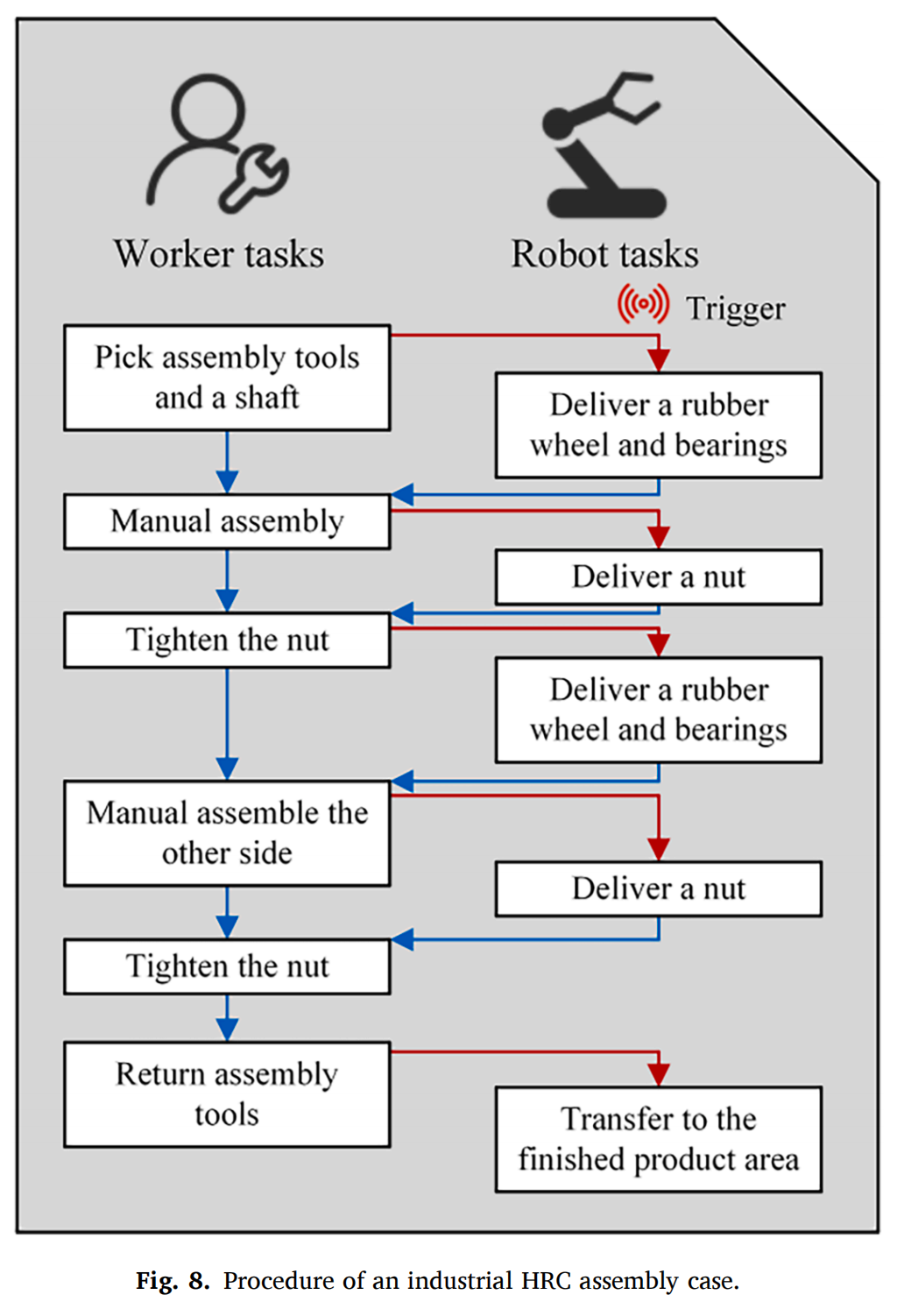

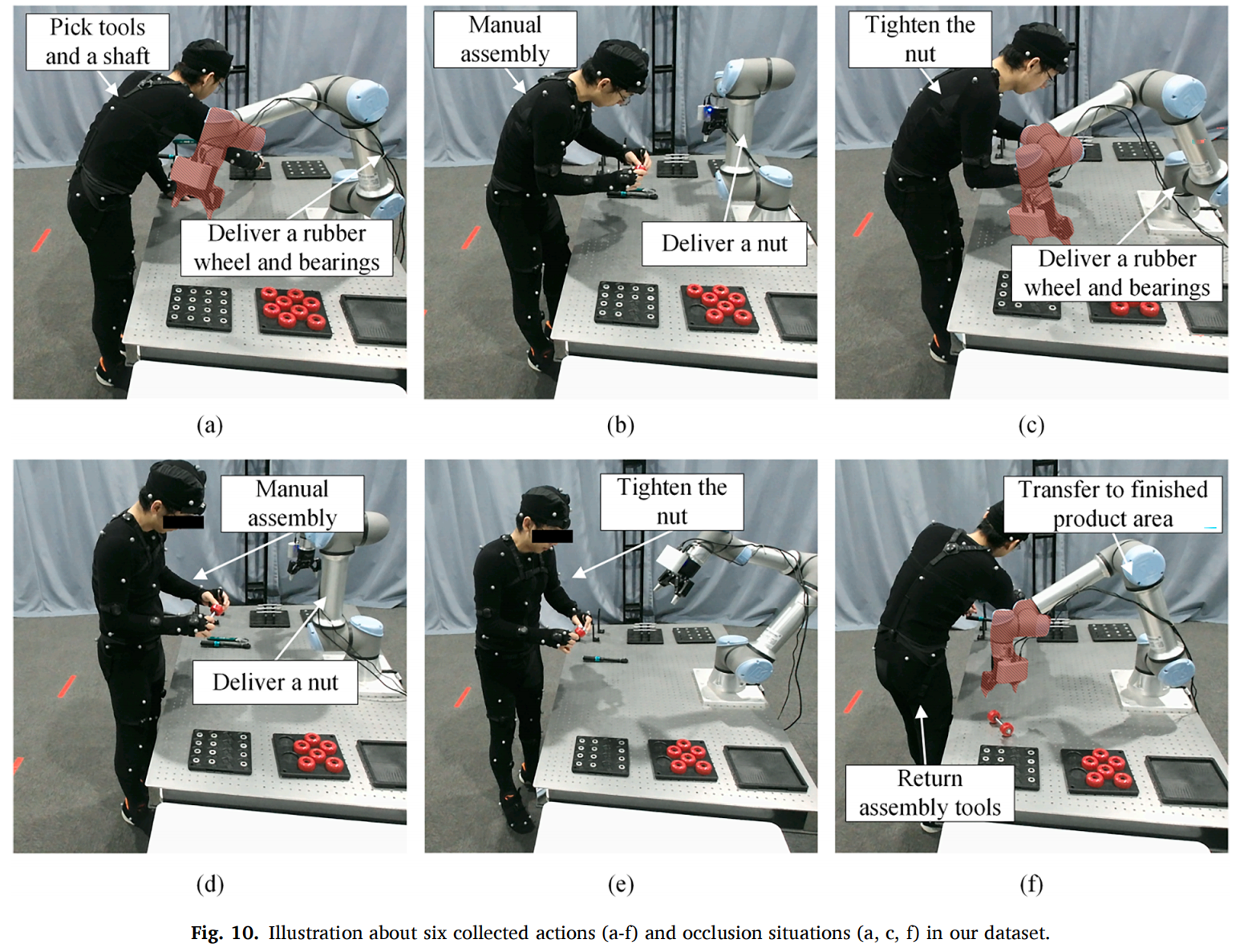

3、a. 在两个公共数据集和一个合成遮挡数据集上进行的实验,证明了本文方法的竞争力和遮挡鲁棒性。b. 开发了一个包含视频、IMU 和 3D 真值标注的 HRC 装配过程 HPE 数据集,用于验证应用性能。

本文通过一系列实验验证了基于视觉-惯性融合的人体姿态估计(HPE)方法在不同场景下的性能和鲁棒性。在构建自定义数据集时,利用NOKOV度量光学动作捕捉系统获取高精度的真值数据,以评估本文方法的准确性(图9、10、11)。

NOKOV度量动作捕捉系统提供高精度人体姿态真值,助力验证本文方法。

作者简介:

王柏村(通讯作者),浙江大学机械工程学院副院长、百人计划研究员、博士生导师;

宋词,浙江大学机械工程学院博士研究生;

李兴宇,普渡大学工程技术学院助理教授;

周慧颖,浙江大学机械工程学院博士研究生;

杨华勇,中国工程院院士、浙江大学工学部主任、机械工程学院教授、博士生导师;

王力翚,加拿大工程院院士、瑞典皇家理工学院可持续制造学教授及系主任。