来自吉林大学人工智能学院的副研究员高一星,在机器人领域顶级国际会议ICRA 2023中发表了机器人辅助穿衣(Assistive Dressing)及衣物抓取的研究新进展。其中,NOKOV度量动作捕捉系统为研究提供了衣物抓取点实时位姿数据。

研究成果一

基于RGB-D语义分割的衣物抓取和展开

在智能机器人养老助残中,机器人辅助穿衣是一项极具挑战性的任务,而衣物的抓取和展开是机器人辅助穿衣任务的关键和核心。一些研究主要基于单输入的多噪声深度图像训练可抓取点的识别模型,同时通过合成数据来降低数据标注成本,然而噪声影响以及合成域与真实域之间的特征分布差异往往会导致性能的下降。这种基于预测点坐标的思路也往往会因为衣物等柔性物体的形变遮挡而导致任务失败。

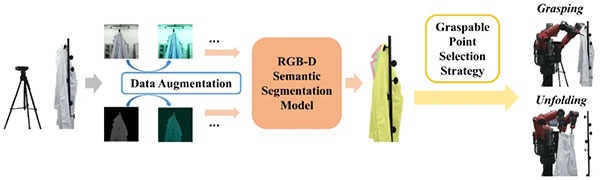

因此,高一星团队提出了RGB-D语义分割模型(Bi-directional Fractal Cross Fusion Network,BiFCNet)来识别包含更多语义信息的区域,从而实现机器人对目标衣物可抓取区域的预测和估计。为了降低模型训练的高数据标注成本,高一星团队还提出了一个基于对抗策略的多输入数据增强方法。最后,基于考虑抓取方向的可抓取点选择方法设计了整个系统以及抓取和展开任务流程。

基于数据增强、RGB-D语义分割、可抓取点选择策略的衣物抓取和展开流程

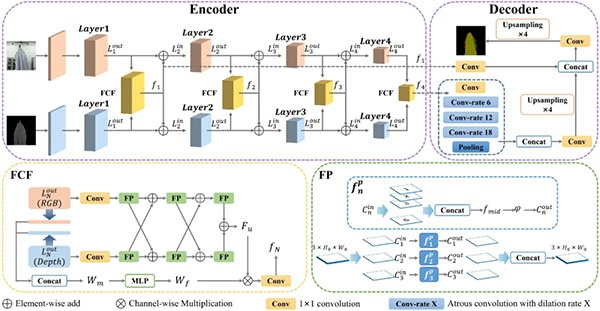

针对提出的RGB-D语义分割模型BiFCNet,整个网络采用编码器-解码器结构。编码器部分由两个并行的ResNet-101网络构成并作为主干特征提取网络。ResNet-101每一层的输出在(Fractal Cross Fusion,FCF)模块中进行融合。在FCF特征融合模块中分别设置了两种特征处理路径:通道权重提取和交叉融合传播。交叉融合传播路径中的分形过程(Fractal Process,FP)模块可以基于分形几何提取全局复杂特征。两条路径最终收敛从而获得融合的特征图。DeepLab V3+被用作特征解码器,第一个和最后一个FCF模块的融合结果被用作DeepLab V3+网络的浅层特征输入和深层特征输入。最后,解码器执行特征解码输出分割图。

RGB-D语义分割网络(Bi-directional Fractal Cross Fusion Network,BiFCNet)

以上研究成果以“Clothes Grasping and Unfolding Based on RGB-D Semantic Segmentation” 为题,被2023 IEEE International Conference on Robotics and Automation (ICRA)接收。原文链接:https://doi.org/10.48550/arXiv.2305.03259

研究成果二

面向机器人辅助穿衣中衣物展开的跨域表示学习网络

关于机器人智能辅助穿衣(Assistive Dressing),现有的研究工作通常关注辅助穿衣的过程,假设衣物已经被机器人抓住。但是在辅助穿衣之前,机器人应该首先将衣物展开至可穿的状态。

在机器人衣物展开研究中,准确识别衣物的抓取点是最关键的步骤之一。随着深度学习的出现,研究者们开始使用卷积神经网络从大规模标记数据中学习抓取点的笛卡尔坐标。然而,采集带有标记信息的真实数据是非常耗时耗力的。因此,使用物理引擎生成合成图像来增强训练数据集已经成为机器人展开衣物研究中广泛采用的范式。

Baxter人形机器人自动识别悬挂衣服的抓取点,并将衣服展开至可穿的状态,辅助用户穿衣

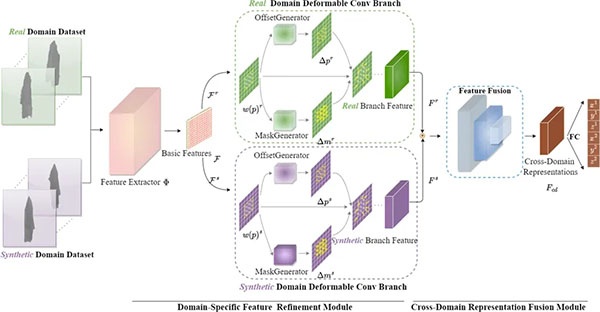

针对真实图像和合成图像之间存在的固有的领域差异,高一星团队提出了一个跨域表示学习(Cross-Domain Representation Learning,CDRL)网络,该网络能够充分地从合成域和真实域中提取知识,以产生更鲁棒的跨域特征表示。CDRL网络主要由两个模块组成,其中,领域特定特征细化模块提取与领域无关的图像特征,然后通过两个领域感知的可变形卷积分支自适应地对这些特征进行细化,生成领域特定的知识;跨域特征表示融合模块通过融合两个领域分支的特征来获得跨域表示,从而集成了特定领域的知识,提高了模型识别的准确性。

跨域表示学习(Cross-Domain Representation Learning,CDRL)

在实施细节方面,高一星团队利用Maya物理引擎生成大规模带有抓取点标记信息的合成衣物图像,并通过NOKOV度量动作捕捉系统采集带有衣物抓取点标记信息的真实深度图像。与5种基线方法相比, CDRL方法在衣物抓取点识别上达到了更好的效果,进一步地降低了识别误差。将模型部署到Baxter机器人上,展开衣服后,通过识别真实用户的实时关节位置,机器人辅助6名用户完成了穿衣动作。

以上研究成果以“Cross-Domain Representation Learning for Clothes Unfolding in Robot-Assisted Dressing” 为题,被2022 ECCV Workshop on Assistive Computer Vision and Robotics接收。原文链接:https://doi.org/10.1007/978-3-031-25075-0_44

结语与未来

高一星领导的吉林大学人形机器人与视觉团队,为机器人衣物抓取和展开以及机器人辅助穿衣提供了新的思路,随着机器人路径规划方法的完善和模型识别精度以及动作捕捉性能的提升,我们可以期待更加成熟的机器人辅助穿衣解决方案。未来随着技术成果转化的全面商业落地,我们将会看到人形机器人在智慧医疗、养老助残、家居服务以及科学研究等领域开辟更大的市场。

关于高一星